Python爬虫-scrapy基本使用

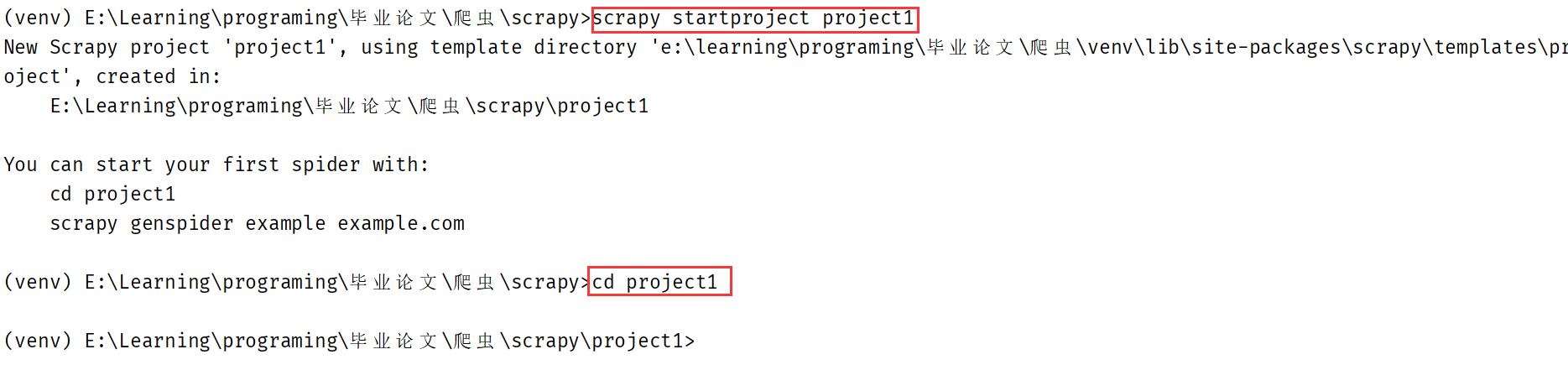

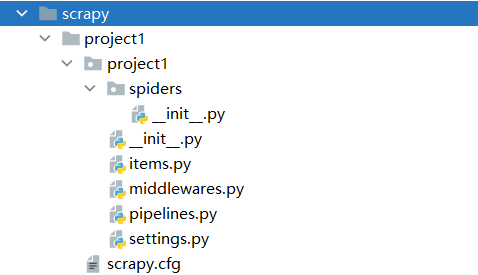

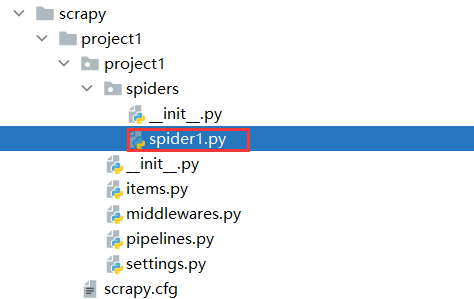

创建工程:scrapy startproject project_name

切换到工程目录后创建爬虫文件:scrapy genspider spider_name www.xxx.com

执行工程:scrapy crawl spiderName。若要省去输出的繁杂日志,可在settings.py文件中追加LOG_LEVEL="ERROR"只输出错误信息。

爬虫示例

前提:

- 若要突破

robots.txt限制,则将settings.py文件中的ROBOTSTXT_OBEY设为False。 - UA伪装在

settings.py的USER_AGENT设置。

目标:爬取B站当天排行榜内容。

1 | import scrapy |

Selector列表:[<Selector xpath='//li//div[@class="info"]/a/@href' data='//www.bilibili.com/video/BV1xp4y 1b7LX'>, ...]

本博客所有文章除特别声明外,均采用 CC BY-NC-SA 4.0 许可协议。转载请注明来自 Silent Wittgenstein!